In diesem Artikel

Technische Insights-Serie - Evaluierung von Plattformen zum maschinellen Lernen

„Es war bemerkenswert, wie appliedAI dieses Projekt mit zwei Partnern aus unterschiedlichen Branchen bewältigt hat. In einem sehr agilen Prozess waren sie flexibel und behielten trotzdem das Gesamtziel im Auge: uns praktische Erfahrungen mit verschiedenen ML-Pipelines zu vermitteln und eine perfekte Dokumentation und Übersicht zu liefern.“ Dr. Thomas Schröck, Wacker Chemie AG

Pipelines zum maschinellen Lernen (ML) zu reproduzieren, bereitzustellen, zu versionieren und nachzuverfolgen ist ein zentraler Teil des ML-Lebenszyklus und eine der häufigsten Herausforderungen für neu gegründete ML-Teams. Die Arbeitsweise im akademischen Umfeld und in der Industrie entwickelt sich durch steigende Anforderungen an produktionstaugliche Systeme immer weiter auseinander. Somit reifen auch die entsprechenden Prozesse und Arbeitsabläufe.

Traditionelle Tools im Software-Engineering wie Issue-Tracker, Versionskontrolle und Kollaborationstools spiegeln die zusätzliche Komplexität des ML-Lebenszyklus nicht adäquat wider. Gleiches gilt für Data-Science-Tools wie Notebooks oder Bibliotheken für das Modelltraining. Diese Lücke ist besonders ausgeprägt bei Funktionen, mit denen Daten und Modelle verwaltet werden sollen. Für Pipelines des maschinellen Lernens sind diese zentral.

Daher verspricht eine Vielzahl von Open-Source- und kommerziellen Anbietern, das Management von ML-Pipelines zu erleichtern. Da die Landschaft unausgereift ist, hat sich noch keine de-facto Standard-Toolchain im Markt etabliert. Somit stehen Unternehmen, die strategische Entscheidungen über ihre Toolchain treffen wollen, vor einem unmittelbaren Problem.

Motivation für die Evaluierung von ML-Pipelines

appliedAI wurde von seinen Partnern Wacker und Infineon zu diesem Problem angesprochen. Beides sind große deutsche Unternehmen, die Teams für das maschinelle Lernen haben.

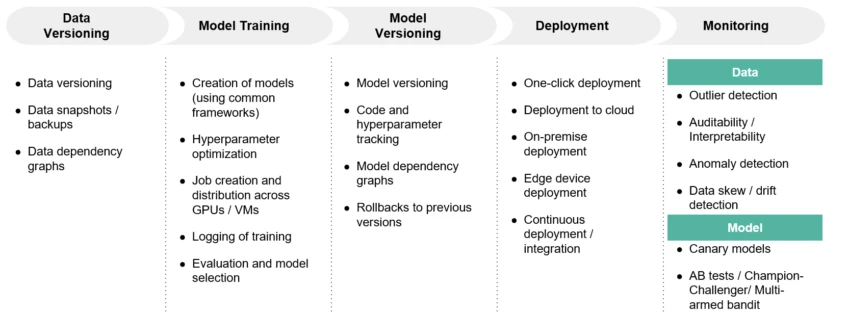

Gemeinsam mit diesen Partnern evaluierte appliedAI durchgängige und modulare Tools, mit denen ML-Pipelines verwaltet werden können. In diesem Projekt war appliedAI besonders an Tools interessiert, welche die Datenversionierung, das Modelltraining, die Modellversionierung, die Modellbereitstellung sowie die Daten- und Modellüberwachung erleichtern. Um im Rahmen der ML-Plattform Evaluierung zu bleiben, befasste sich die Evaluation nicht mit Tools für das Wrangling, Speicherung oder Verarbeitung von Daten.

Die Infineon Technologies AG ist ein deutscher Hersteller von Halbleitern mit Sitz in Neubiberg. Infineon ist 2017 dem Partnernetzwerk von appliedAI beigetreten. Das Unternehmen hat über 40.000 Mitarbeitende und gehört zu den zehn größten Halbleiterherstellern weltweit. Es ist ein Marktführer für Automobil- und Leistungshalbleiter. Im Geschäftsjahr 2019 erzielte das Unternehmen einen Umsatz von 8,0 Mrd. EUR.

Die Wacker Chemie AG ist ein deutsches multinationales Chemieunternehmen aus München. Wacker ist 2017 dem Partnernetzwerk von appliedAI beigetreten. Das Unternehmen beschäftigt über 14.000 Mitarbeitende und betreibt 24 Produktionsstätten in Europa, Asien und Amerika.

Wir stellten uns folgende Fragen: Wie können wir eine ML-Pipeline evaluieren? Welche Schritte müssen wir durchlaufen? Und welche kritischen Aspekte müssen wir beim Entwickeln der ML-Pipeline berücksichtigen? Im folgenden Artikel lesen Sie, wie der Evaluierungsprozess der ML-Pipelines für Wacker und Infineon aussah, mit welchen Problemen die Unternehmen beim Einsatz von maschinellem Lernen konfrontiert waren und welchen Ansatz appliedAI verfolgte, um die Pipelines aufzubauen und zu evaluieren.

Herausforderungen beim Aufbau skalierbarer ML-Pipelines

Wacker und Infineon haben beide ihre ersten Projekte mit maschinellem Lernen (ML) erfolgreich durchgeführt und verbessern so die Arbeit verschiedener Geschäftsbereiche.

Sowohl Wacker als auch Infineon hatten eigene ML-Teams und erweiterten zunehmend den Umfang ihrer Arbeit.. Sie stellten jedoch schnell mehrere Mängel in ihrem Arbeitsablauf fest. Dazu gehörte, dass sie die Modelle manuell tracken und bereitstellen mussten.

Die Organisation vieler verschiedener Daten- und Bereitstellungs- Pipelines stellte eine weitere Herausforderung dar. Die Knoten für das Training von ML-Modellen bereitzustellen, war extrem zeitaufwendig. Außerdem ist die Reproduzierbarkeit ein wichtiges Kriterium in den Branchen der beiden Unternehmen.

Infineon und Wacker wollten ihre ML-Teams vergrößern und benötigten daher eine Lösung für diese Probleme. Somit traten sie an appliedAI mit der Absicht heran, in einem gemeinsamen Projekt verschiedene Arten von ML-Pipelines zu evaluieren.

Methodischer Ansatz zur Auswahl von ML-Pipelines

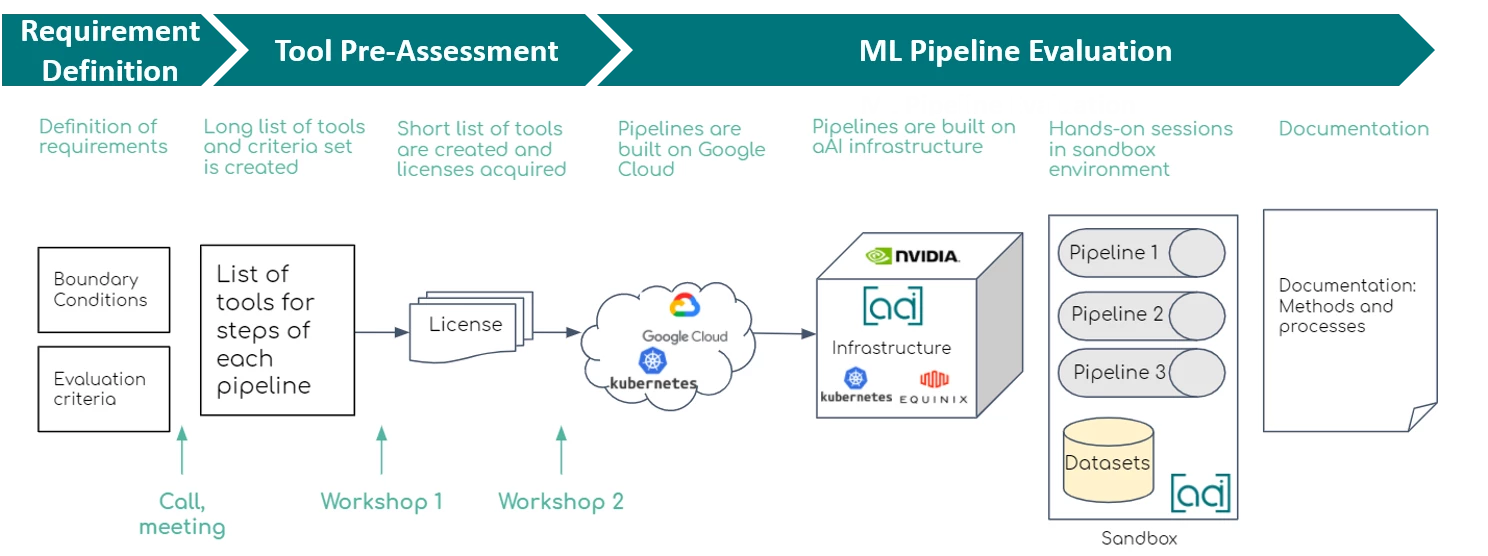

Infineon und Wacker hatten das Ziel, an ML-Projekte strukturiert heranzugehen, die Desorganisation zu bewältigen und das Risiko rechtlicher Konsequenzen zu senken. Um bei der Zielerreichung zu helfen, evaluierte appliedAI verschiedene ML-Plattformen. Das Projekt folgte einem dreistufigen Prozess.

appliedAI definierte zuerst die Anforderungen, die für die Partner am wichtigsten waren. Anschließend erstellte das Team eine Liste von Tools für jeden Schritt der Pipeline und untersuchte, inwiefern sie für die Basisanforderungen anwendbar sind.

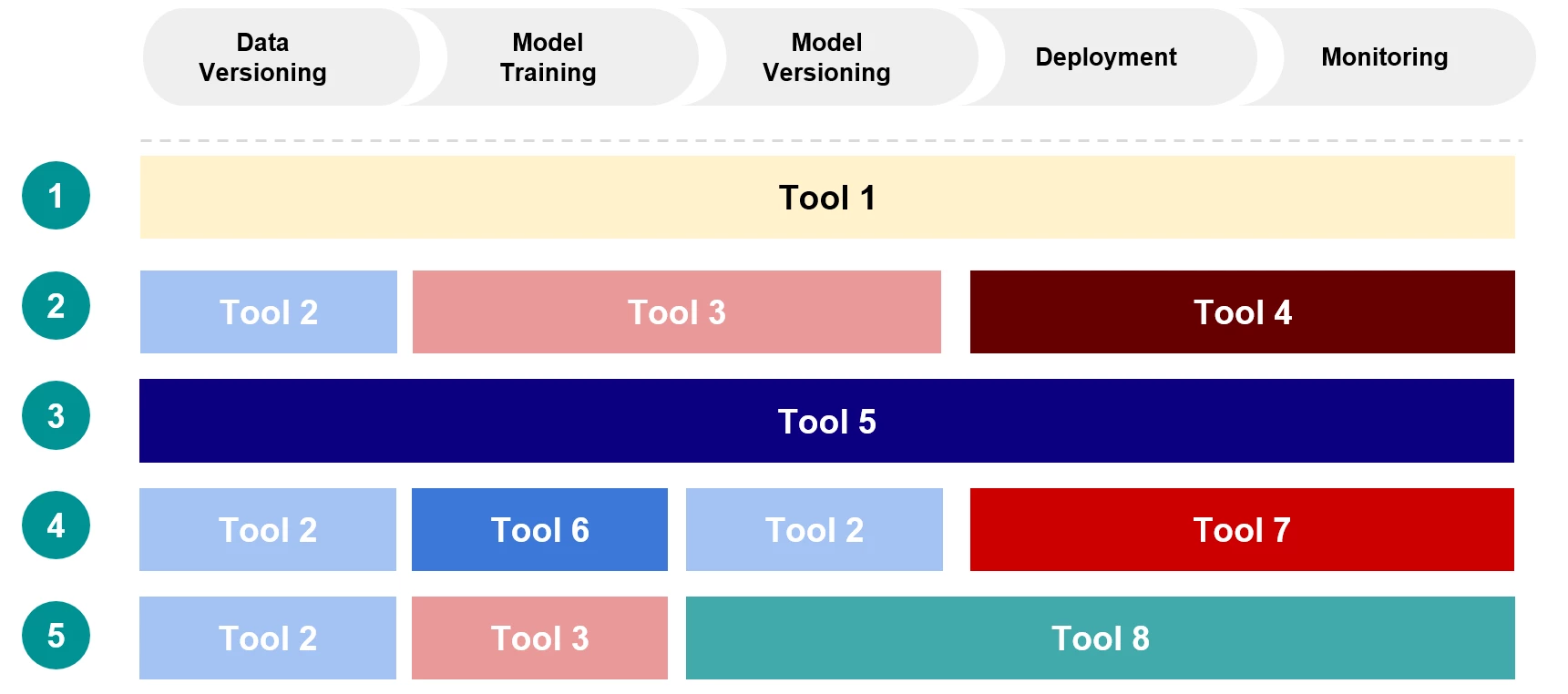

In der zweiten Phase - Vorabbewertung der Tools - erstellten wir eine Shortlist von acht Tools, welche die Basis für die fünf ML-Pipelines bildeten. Das appliedAI-Team kontaktierte dann die entsprechenden Tool-Anbieter, um Unterstützung, Hilfe und Testlizenzen für die ausgewählten Tools zu erhalten. Nachdem wir auf alle Tools zugreifen konnten, stellte appliedAI sie auf der Infrastruktur der Initiative und in der Google Cloud bereit.

Alle fünf ML-Pipelines wurden dann anhand der in Phase 1 definierten Kriterien bewertet. Im letzten Schritt erstellten wir die notwendige Dokumentation über Prozesse und Pipelines, die als Grundlage für die Evaluierung diente. Einen genaueren Einblick in die Phasen beschreiben wir nachfolgend.

Evaluierungsschritte für ML-Pipelines im Detail

Phase 1: Definition der Anforderungen

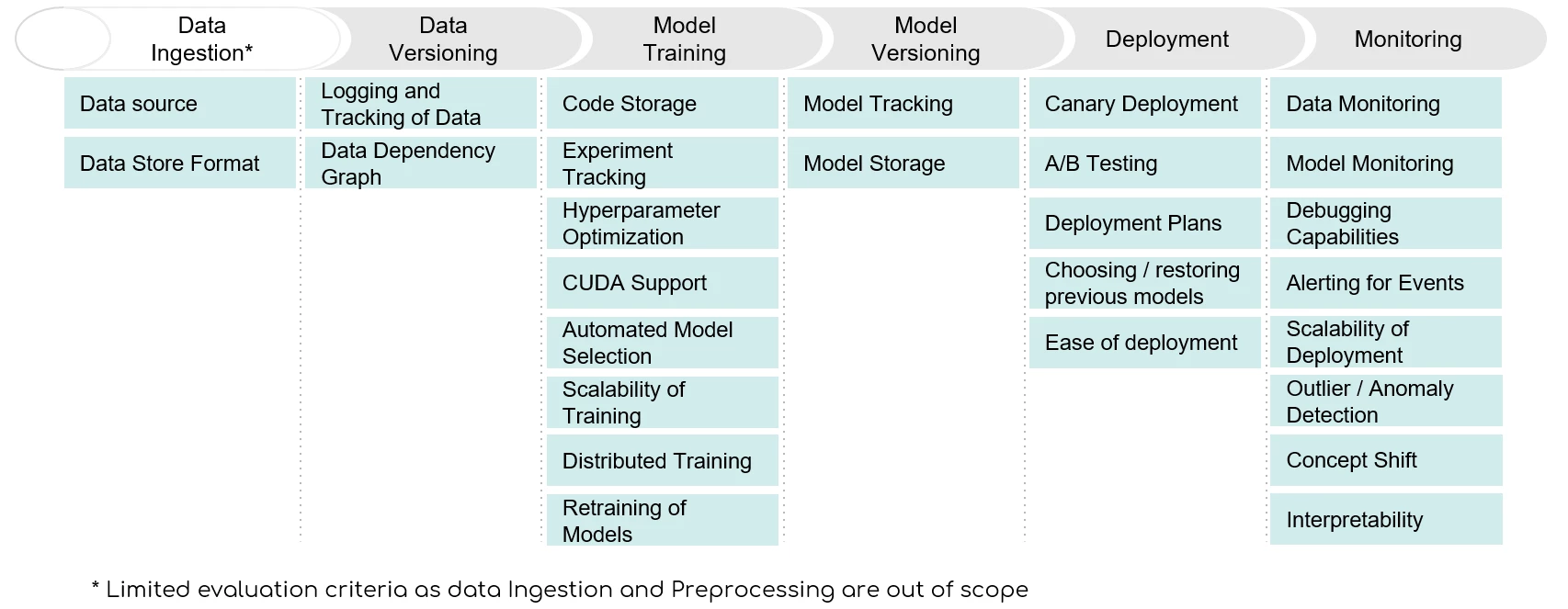

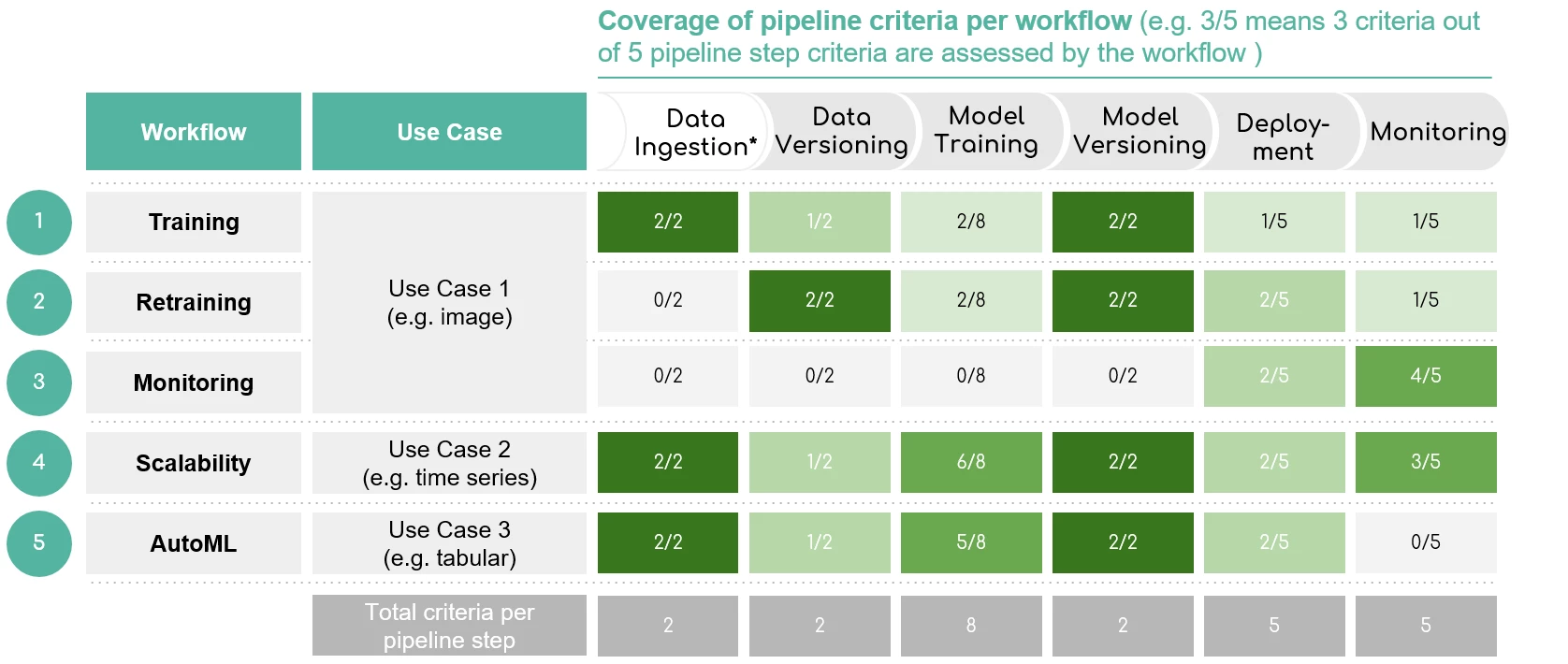

Zu Beginn definierten wir den Umfang, die Anforderungen und mehrere Bewertungskriterien, um die Bedürfnisse der Partnerunternehmen zu evaluieren. Innerhalb dieser Definition hat appliedAI fünf entscheidende Stufen für die Bewertung der ML-Pipeline festgelegt: Datenversionierung, Modelltraining, Modellversionierung, Modellbereitstellung sowie Daten- und Modellüberwachung.

Darüber hinaus identifizierten wir verschiedene Ansätze, um eine Pipeline zu entwerfen – von modularen Tools bis hin zu End-to-End-Ansätzen. Zudem definierten wir in einem mehrstufigen Ansatz diverse Kriterien.

Anhand dieser richteten wir unsere Evaluierung an den vordefinierten Bedürfnissen von Wacker und Infineon aus.

- Zuerst erstellte appliedAI für die Teams der beiden Partnerunternehmen einen Fragebogen mit spezifischen Anforderungen und deren relativer Wichtigkeit. Die festgelegten Kriterien der beiden Teams diskutierten wir dann in der Gruppe und reduzierten sie auf die Wichtigsten.

- Zweitens kategorisierten appliedAI und die ML-Teams die Kriterien entlang bestimmter Dimensionen, z. B. ob sie Dealbreaker und damit nicht verhandelbar sind, oder ob es sich um Kriterien handelt, die bei der Tool-Evaluation bewertet werden sollten. So wurden in verschiedenen Phasen des Projekts unterschiedliche Kriterien angewandt. Beispielsweise verwendeten wir bestimmte Kriterien in Phase 2, um Tools aus der Longlist herauszufiltern und so die Shortlist zu erstellen. Zusätzlich teilten wir die Kriterien in die fünf oben genannten Stufen der Pipeline ein.

- Drittens erstellte appliedAI eine vorläufige Gewichtung für alle Kriterien und schätzte damit ihre relative Wichtigkeit ein. Wacker und Infineon konnten diese Gewichtung interaktiv anpassen.

Phase 2: Vorabbewertung der Tools

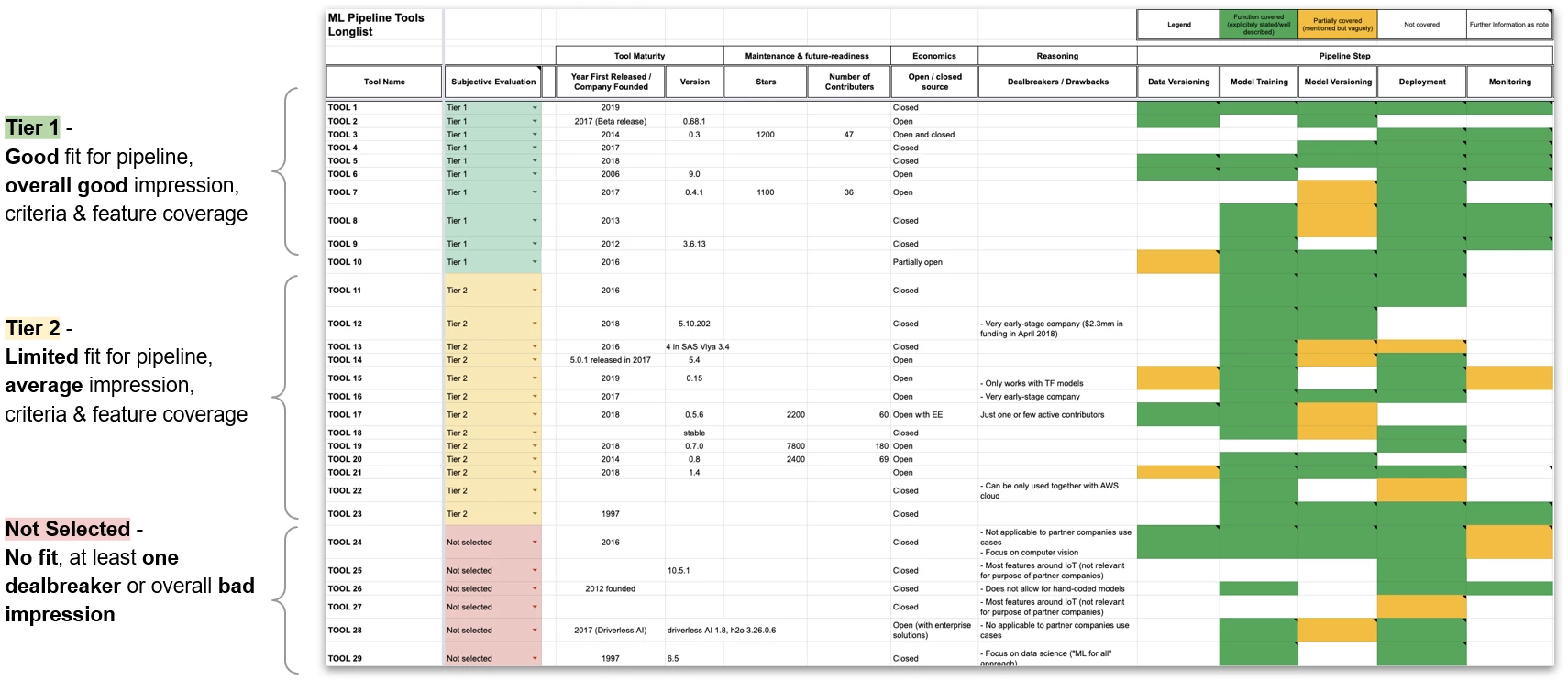

Diese Informationen trugen wir anhand öffentlich zugänglicher Informationen zusammen. Die in der Longlist aufgeführten Tools teilten wir dann in Tier 1, Tier 2 und nicht ausgewählte Tools ein.

- Tools in Tier 1 betrachteten wir als gut geeignet für die Pipeline. Sie boten einen guten Gesamteindruck, Funktionsumfang und gute Kriterien.

- Tools in Tier 2 waren nur bedingt für die Pipeline geeignet und boten nur einen durchschnittlichen Gesamteindruck.

- Tools der Gruppe nicht ausgewählt enthielten mindestens einen Dealbreaker und boten einen schlechten Gesamteindruck. Sie waren somit nicht geeignet.

Phase 3: Evaluierung der ML-Pipelines

Im nächsten Schritt stellte appliedAI die Tools zum Teil auf der Google Cloud Kubernetes Engine und zum Teil auf dem hauseigenen Kubernetes-Cluster von appliedAI bereit. Dieser Prozess wurde von einem funktionsübergreifenden Projektteam mit ML- und DevOps-Experten unterstützt.

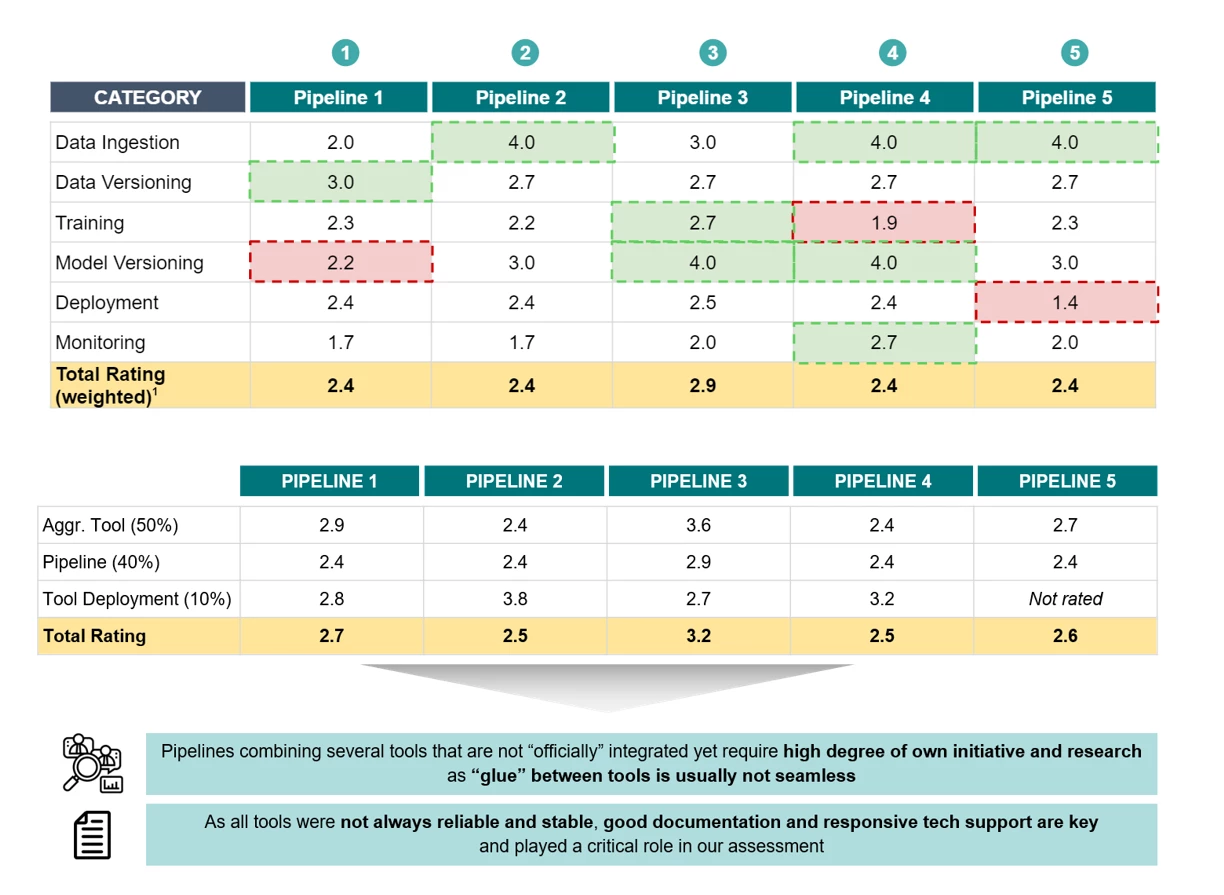

Anschließend evaluierte appliedAI die fünf ML-Tools bzw. integrierten Pipelines der Shortlist. Dafür stellte das Team eine Reihe von Fragen zusammen, die beim Evaluieren der Pipeline beantwortet werden sollten. Die Kriterien wurden auf Tool- und Pipeline-Ebene betrachtet, um eine ganzheitliche Sicht auf die eingesetzten Pipelines zu erhalten.

Zusätzlich konnten die Teams von Wacker und Infineon auf die Tools auf der Infrastruktur von appliedAI zugreifen. Somit konnten sie die Tools selbst ausprobieren und eigenständig evaluieren. Während des gesamten Prozesses unterstützte appliedAI die Teams von Wacker und Infineon.

Der Fragenkatalog ergänzte den zu bewertenden Kriterienkatalog. Die vielfältigen Möglichkeiten von ML-Pipelines wurden dann anhand von fünf zusammengestellten ML-Workflows getestet. Die fünf bewerteten Workflows waren Training, Speicherung, Überwachung, Skalierbarkeit sowie AutoML.

Im letzten Schritt diskutierten wir die Erkenntnisse und Ergebnisse der Evaluation im gemeinsamen Projektteam mit Wacker und Infineon. Während des gesamten Projekts traf sich das Projektteam, bestehend aus Experten von appliedAI, Wacker und Infineon, regelmäßig zu Projektmeetings. In diesen wurde im Sinne eines agilen Prozesses konkretes Feedback zu Arbeitsschritten gegeben und Änderungen dann konsequent, zielorientiert und flexibel eingearbeitet – passend zu den Ergebnissen der Diskussionen und den Anforderungen.

Fazit der Evaluation: Chancen, Grenzen und Empfehlungen

"appliedAI hat einen großartigen Job gemacht bei der Verwaltung dieses Projekts mit mehreren Kunden. Sie haben uns auf agile Weise durch die verschiedenen Projektphasen geführt, waren immer aufgeschlossen, haben aber nie den Fokus verloren. Wir haben praktische Erfahrungen gesammelt und konnten von der profunden technischen Erfahrung des appliedAI-Projektteams profitieren. Auf dieser Basis und dem gemeinsam erarbeiteten Blueprint fühlen wir uns sicher, dieses Thema weiter zu verfolgen" C. Ortmaier, Infineon Technologies AG

Drei Erkenntnisse stachen am Ende des Projekts hervor.

- Erstens haben die Tools mit einer einzigen Benutzeroberfläche und durchgängigen Lösungen oft deutliche Vorteile. Viele modulare Tools waren auf eine komplexe Konfiguration angewiesen und wiesen versteckte Abhängigkeiten und Versionskonflikte auf. Diese führten zu einem hohen Gesamtaufwand bei der Einrichtung. Andererseits boten modulare Tools manchmal Funktionen, die noch nicht in End-to-End-Lösungen integriert waren.

- Zweitens lassen sich die derzeit erhältlichen Tools schlecht integrieren und hinken den Toolchains anderer Software-Engineering-Bereiche stark hinterher. appliedAI prognostiziert ein riesiges Potenzial für ML-Tooling-Start-ups, da der Markt noch nicht erschlossen ist.

- Drittens zeigten viele der Tools schwerwiegende Betriebsprobleme und waren somit weniger stabil. Dies verdeutlicht das frühe Stadium, in dem sich das ML-Tooling derzeit befindet.

Im Gegensatz zu den einzelnen Tools liegt die Bewertung für die jeweiligen Pipelines deutlich näher beieinander. Schwächen in einer Kategorie werden durch Stärken in anderen ausgeglichen. Einen überragenden „Alleskönner“ gibt es nicht.

Am Ende des Projekts hatten die Teams von Infineon und Wacker tiefe Einblicke in die aktuelle Tool-Landschaft und verstanden die Fallstricke und Herausforderungen beim Aufbau von Pipelines für das maschinelle Lernen. Ebenso kannten sie nun die Alleinstellungsmerkmale der verschiedenen Toolchains.

Rückblickend erreichte appliedAI bei diesem Projekt zur Erstellung einer ML-Pipeline eine hohe Kundenzufriedenheit. Grund dafür war die umfassende Erfahrung mit den Tools sowie die effiziente Teamarbeit und Zusammenarbeit. Darüber hinaus bot appliedAI einen praktischen Zugang zu den Tools und einen reibungslosen Übergang von persönlichen zu Online-Meetings.

Autoren der Fallstudie und ML-Pipeline-Projektteam.

- Dr. Denise Vandeweijer, Director AI Solutions & Projects

- Stephanie Eschmann, Senior Product Marketing Manager bei appliedAI Initiative

- Sebastian Wagner, Senior AI Engineer

- Moritz Münker, Software Engineer- AI

- Alexander Machado, Team Lead MLOps Processes bei appliedAI Initiative

- Adrian Rumpold, Head of MLOps Engineering bei appliedAI Initiative

- Anica Oesterle, AI Engineer & Product Lead

- Patrick Tu, Junior AI Engineer

In Partnerschaft mit: Infineon Technologies AG and Wacker Chemie AG

Haben Sie Fragen zur Partnerschaft? Sprechen Sie mit uns

Leider können wir das Formular ohne Ihre Zustimmung nicht anzeigen. Wir verwenden Hubspot Formulare, die funktionale Cookies setzen. Bitte akzeptieren Sie funktionale Cookies in den Einstellungen, um das Kontaktformular nutzen zu können. Oder schreiben Sie uns eine E-Mail an info@appliedai.de.